Das Potpourri aus über 100 Vorträgen, Diskussionen, Seminaren und Workshops, das der BDÜ vergangenes Wochenende beim BDÜ-Kongress in Bonn hingezaubert hat, kann ein einzelner Mensch gewiss nicht würdigen. Deshalb ist mein kleiner Bericht auch nur ein ganz persönlicher Erfahrungsausschnitt. Sämtliche Abstracts und Artikel lassen sich viel besser im Tagungsband nachlesen.

Mein erster Gedanke auf dem Heimweg nach dem ersten Kongress Tag war: Wie DeepL, einer Art Naturphänomen gleich, mit einer Mischung aus Faszination und Entsetzen studiert wird, das erinnert mich stark daran, wie vor etwa 15 Jahren alle staundend auf Google blickten und versuchten, sein “Verhalten” zu ergründen. Ein wenig tat mir das arme DeepL schon leid, leistet es doch für eine Maschine wirklich Beträchtliches, und doch erntet es unter Sprachmittlern allenthalben Häme für die – zugegebenermaßen of lustigen – Fehler, die es produziert. Glücklicherweise blieb es aber nicht dabei: Zumindest für mich gab es in einigem hochinteressanten Vorträgen durchaus Neues und Interessantes in Sachen maschineller Übersetzung zu hören.

Patrick Mustu über DeepL im Übersetzen von Rechtstexten für das Sprachenpaar Englisch-Deutsch

Patrick Mustu lieferte eine fundierte wie unterhaltsame Darstellung dessen, was DeepL mit Rechtstexten so anstellt. Was mir dabei besonders im Gedächtnis geblieben ist:

- DeepL liefert zu verschiedenen Zeitpunkten für denselben Text unterschiedliche Übersetzungen. The parties hereto waren an einem Tag Die Parteien hieran, am nächsten die Beteiligten.

- DeepL schaut nicht in die amtlichen Übersetzungen von EU-Rechtstexten. Für Rechtskundige und Normalsterbliche ganz geläufige Abkürzungen wie DSGVO wurden nie übersetzt.

- Die so genannten Doublets (any and all, null and void, terms and conditions) und Triplets (right, title and interest) werden nicht als Sinneinheiten erkannt, sondern einzeln wortwörtlich übersetzt. Sie veranschaulichen gut, was Patrick Mustu mit Blick auf den übersetzerischen Balanceakt zwischen Freiheit und Genauigkeit sehr schön auf den Punkt gebracht hat hat mit dem denkwürdigen Satz “Auch Übersetzer sind Interpreter.”

Kurzseminar von Daniel Zielinski und Jennifer Vardaro über das Terminologieproblem in der maschinellen Übersetzung

In diesem für mich ultraspannenden Seminar wurde gezeigt, wie man die Algorithmen von online verfügbaren MÜ-Systemen mit kundenspezifischer Terminologie füttern, also trainieren kann. Dank dieser engine customization kann man dem System dabei helfen, sich bei einer Auswahl möglicher Termini für den jeweils “richtigen” zu entscheiden. In manchen Texten trägt die Terminologie den Großteil der Inhalte, sie ist außerdem SEO-relevant. Deshalb ist eine verbesserte Terminologie von entscheidender Bedeutung für die Qualität der Übersetzung.

Die Referenten hatten eine Reihe kommerziell verfügbarer Systeme getestet, unter anderem Amazon, Globalese, Google, Microsoft und SDL. Es gab jeweils eine Demonstration der Benutzeroberflächen, der Preismodelle und eine Auswertung der Ergebnisse. Hierbei wurde die mittels Einspeisen eigener Terminologie erzielte Reduzierung der Terminologiefehler gewichtet nach Kritikalität dargestellt – sie lag teilweise bei über 90 %.

Interessant: Das Importieren von “nackter” Terminologie brachte im Vergleich nicht so gute Ergebnisse wie das Eispielen ganzer Sätze – in einigen Fällen verschlechterten sich die Übersetzungen sogar. Die Bedeutung von Kontext, Kontext, Kontext scheint also auch in der MÜ eine große Rolle zu spielen.

Als ich später den “Terminologiepapst” Klaus-Dirk Schmitz nach den Megatrends in der Terminologie fragte, nannte er im Übrigen spontan – unter anderem – auch die Frage, wie man Terminologie sinnvoll in die MÜ integriert. Offensichtlich lag das Seminar von Daniel Zielinski und Jennifer Vardaro also voll im Megatrend!

Nina Cisneros – Schriftdolmetschen

Den Übergang vom Schreiben zum Sprechen schaffte ich dann mit dem Vortrag von Nina Cisneros zum Thema Schriftdolmetschen, auch Livetranskription oder Live Captioning genannt. Dieses “Mitschreiben” in Echtzeit erfolgt normalerweise einsprachig und dient der Hörunterstützung, meist für Menschen mit Hörbehinderung. Wie im Simultandolmetschen arbeitet man zu zweit, um einander aufgrund der hohen kognitiven Belastung regelmäßig abzuwechseln und auch zu korrigieren und zu unterstützen.

Sowohl die konventionelle Methode des Schriftdolmetschens, also mit Händen und Tastatur, als auch die softwarebasierte mittels Nachsprechen des Gesagten und Transkription per Spracherkennungssoftware, hier Dragon (unter Zuhilfenahme eines Silencer genannten Schalldämpfers), wurden demonstriert.

Inspirierend war die anschließende Diskussion über Zusatzdienstleistungen, die im mehrsprachigen Konferenzdolmetschen im Zusammenhang mit Schriftdolmetschen angeboten werden könnten. Bei einer Art sprachmittelndem Schriftdolmetschen oder schriftlichem Simultandolmetschen könnte das Gedolmetschte statt per Mikrofon und Kopfhörer in Schriftform auf einen großen Bildschirm, einer Live-Untertitelung gleich, oder per App auf mobile Endgeräte der Zuhörer übertragen werden. Abgesehen von der Sprachmittlung kann auch hier eine willkommene Hörunterstützung “mitgeliefert” werden: Manche Zuhörer tun sich leichter damit, eine Fremdsprache zu lesen, als sie zu verstehen.

Als Alternative zur Ausgabe unzähliger Kopfhörer wäre eine solche Lösung auch diskret und unkompliziert. Schon heute ist es ja teilweise so, dass man auf das Verteilen von Empfängern verzichtet und stattdessen die Verdolmetschung per Saallautsprecher für alle Zuhörer überträgt (egal ob sie die Ausgangssprache verstehen oder nicht).

Unbeantwortet blieb die Frage, ob man beim Simultandolmetschen statt für die menschlichen Zuhörer auch Dragon-gerecht sprechen kann, also nicht nur deutlich und mit gleichmäßigem Tempo, sondern auch unter Angabe von Satzzeichen und möglichst “druckreif”, also zum Beispiel ohne Selbstkorrekturen. Ich denke Komma es wäre einen Versuch wert Ausrufezeichen

Auch wenn für mich der Charme einer BDÜ-Konferenz unter anderem darin liegt, zu sehen, welche technologischen Neuerungen es bei den Übersetzern gibt (sprich: Was in ein paar Jahren zu den Dolmetschern herüberschwappen könnte), so gab es natürlich auch zum Konferenzdolmetschen viele spannende Vorträge, und zwar nicht nur zum Trendthema RSI. Was ich schon im Sommer beim DfD 2019 bemerkt hatte, bestätigte sich auch hier: Es lohnt sich, Hochschulabsolventen über ihre Masterarbeiten reden zu lassen. So hat Nora Brüsewitz von ihrer Arbeit zur automatischen Spracherkennung als Unterstützung von Simultandolmetschern berichtet. Sie hat hierzu die Systeme von Google, Watson (IBM), Aonix und Speechmatix getestet und anhand der Kriterien Zahlen, Eigennamen, Terminologie, Homophone und unlogische Aussagen evaluiert. In der Gesamtwertung lag Google vorne, bei dem korrekten Transkribieren von Zahlen hatte Watson mit 97 % deutlich die Nase vorne, bei den Eigennamen Google mit 92 % (alle anderen lagen hier deutlich unter 40 %!), im Korrigieren unlogischer Aussagen waren alle Systeme mit zwischen 70 und über 90 % erstaunlich gut (Einzelheiten im Tagungsband, Lesen lohnt sich!) Insgesamt ein Ansatz, bei dem es sich lohnt, die Entwicklungen im Auge zu behalten!

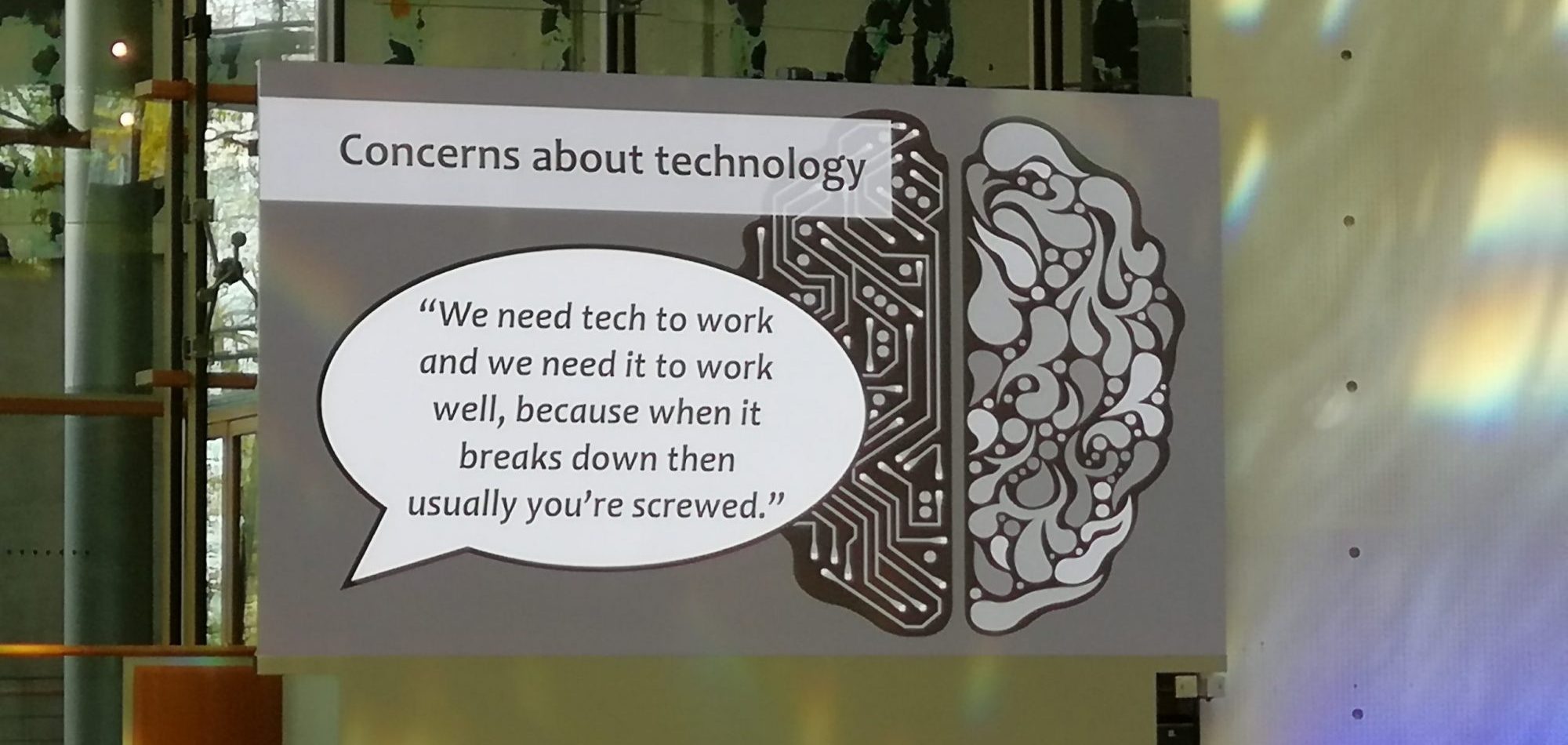

Sarah Fisher stellte die Ergebnisse ihrer Masterarbeit Voices from the booth – collective experiences of working with technology in conference interpreting vor. Die Einzelheiten lassen sich auch hier besser der Arbeit oder dem Tagungsband entnehmen, aber eine sehr aussagekräftige Folie möchte ich gerne für sich sprechen lassen:

Zu guter Letzt hat Claudio Fantinuoli in seinem Vortrag The Technological Turn in Interpreting: The Challenges That Lie Ahead einen willkommenen Perspektivenwechsel vorgenommen und darauf hingewiesen, dass es ohne “neue Technologien” gar kein Simultandolmetschen gäbe. Die großen technischen Entwicklungen, so Claudio, geschehen schnell und unabhängig von uns. Ein besseres Schlusswort hätte ich mir nicht überlegen können.

Und einmal mehr hat sich bestätigt: Das A und O jedes Kongresses sind die Kaffeepausen. Zwar konnte ich mich in den zwei (von insgesamt drei) Tagen nur mit schätzungsweise 0,1 % der über 1000 Teilnehmer unterhalten (und höchstens 10 % der Beiträge hören). Aber ich hätte kaum in zwei Tagen so viele Bücher, Zeitschriften, Blogs, Posts und Webseiten wälzen können, um durch reines Lesen so viele relevante Informationen und Eindrücke zu erhalten, wie ich sie hier von Mensch zu Mensch bekommen habe.

————————

Über die Autorin:

Anja Rütten ist freiberufliche Konferenzdolmetscherin für Deutsch (A), Spanisch (B), Englisch (C) und Französisch (C) in Düsseldorf. Sie widmet sich seit Mitte der 1990er dem Wissensmanagement.

Leave a Reply